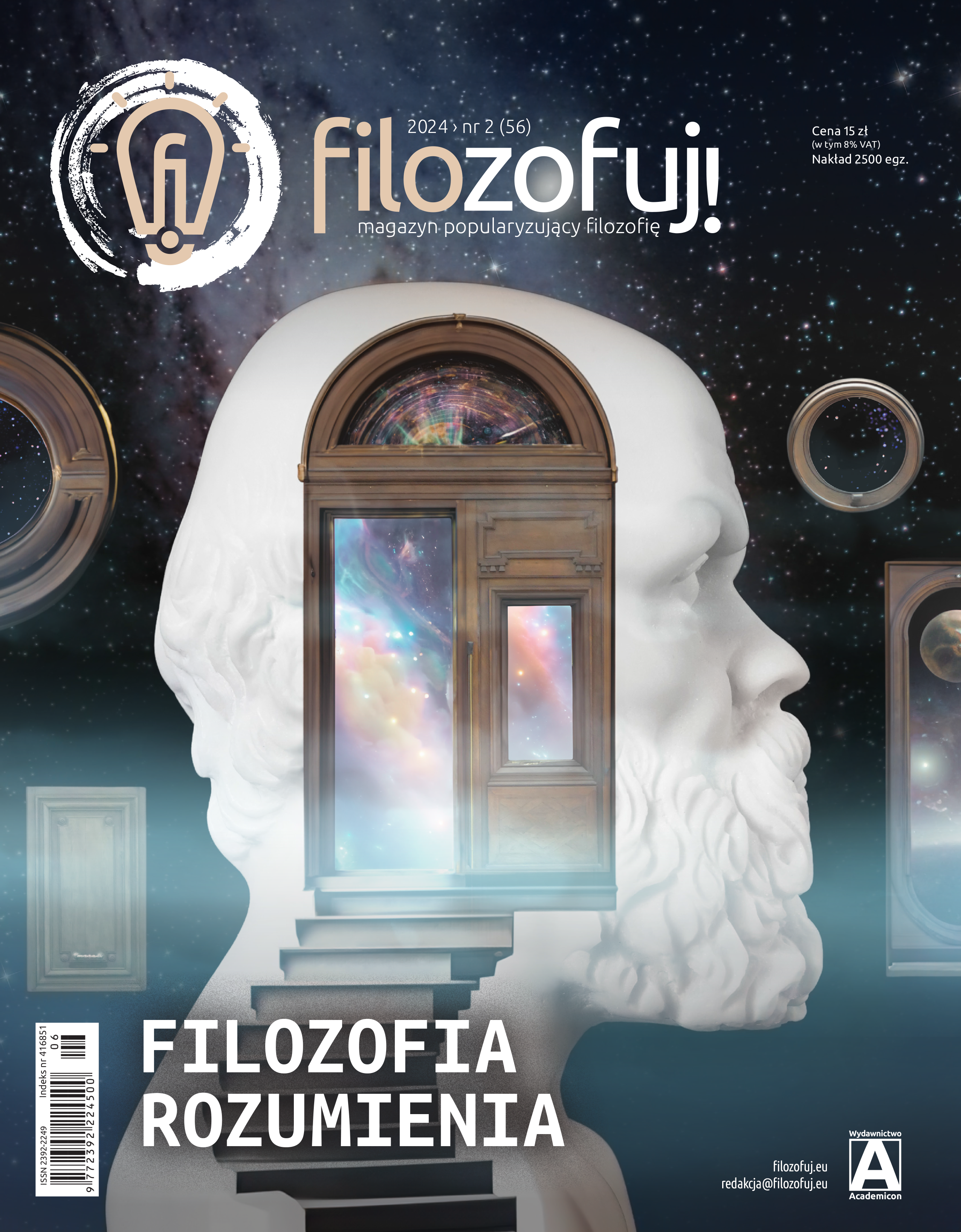

Tekst ukazał się w „Filozofuj!” 2021 nr 1 (37), s. 19–22. W pełnej wersji graficznej jest dostępny w pliku PDF.

Przezwyciężanie barier: metoda analogii i homologii

Podstawowa trudność w rozpoznaniu, czy maszyna uzyskała świadomość, wynika z natury doznań świadomych. Każdy z nas jest dysponentem i „użytkownikiem” własnej świadomości, a wewnętrzne doznania i myśli są niedostępne bezpośrednio i wprost dla zewnętrznego obserwatora. Skąd zatem moglibyśmy wiedzieć, czy inny człowiek lub maszyna są świadome? Oto podstawowy problem.

Trudność tę można nazwać „problemem bariery”. Nie jesteśmy w stanie zajrzeć wprost do umysłów i świadomości innych ludzi (bariera indywidualna). I takie same, a nawet jeszcze większe, kłopoty sprawia bezpośrednia identyfikacja stanów umysłowych u zwierząt (bariera gatunkowa). Podobna trudność dotyczyłaby również np. robotów humanoidalnych – w ich przypadku także nie bylibyśmy w stanie za pomocą tzw. wglądu rozstrzygnąć, czy mamy do czynienia z myślącymi, odczuwającymi maszynami (bariera „rodzajowa”/„materiałowa”).

Problem barier w bezpośrednim dostępie do świadomości innych istot jest wprawdzie poważnym utrudnieniem, ale nie problemem beznadziejnym. Nie wydaje się, aby zamykał on całkowicie możliwość przekonania się, czy inni ludzie i zwierzęta dysponują umysłami. Rozwiązaniem jest dostęp „pośredni”, „nie wprost” do umysłów innych osobników.

Może on być realizowany na dwa sposoby. W pierwszym przypadku dokonujemy dyskretnych rozumowań na temat posiadania przez inne osobniki stanów wewnętrznych, np. bólu lub świadomości, w oparciu o zasadę analogii. Przykładowo, podczas obserwacji zachowania innego człowieka mogę przypisywać mu określone stany umysłowe (np. odczucie i świadomość bólu podczas wyrywania zęba), bowiem na podstawie własnego doświadczenia i samoobserwacji wiem, że temu właśnie zachowaniu towarzyszy świadomie odczuwany ból. Rozumowanie to można niekiedy zastosować wtedy, gdy chcemy przypisać jakieś proste stany wewnętrzne zwierzęciu, którego zachowanie obserwujemy, choć warunkiem w tym przypadku jest to, aby dane zwierzę było morfologicznie jakoś podobne do człowieka i aby zachowywało się w miarę analogicznie.

Innym sposobem obejścia wyjściowej trudności jest posłużenie się rozumowaniem w oparciu o zasadę homologii. W tym przypadku o posiadaniu stanów wewnętrznych u szympansa czy goryla można wnioskować na podstawie budowy i funkcji ich układu neurofizjologicznego. Przykładowo, jeśli u ludzi jakimś stanom wewnętrznym (strach, świadomość etc.) towarzyszy określona aktywność neurofizjologiczna mózgu (biochemiczna, neuronalna etc.), to jeśli istnieją zwierzęta o podobnej strukturze lub aktywności mózgu (biochemicznej, neuronalnej), to jest to jakaś podstawa do przypisania tym zwierzętom możliwości przeżywania analogicznych stanów wewnętrznych (strach, świadomość etc.).

Czy można wykorzystać, chociaż w jakimś stopniu, powyższe metody do rozstrzygnięcia, czy przyszłe inteligentne maszyny będą świadome? Rozpocznijmy od pytania, czy da się rozpoznać świadomość maszyn na podstawie podobieństwa (analogii) w zachowaniu.

Być jak gdyby świadomym: od testu Turinga do superinteligencji

Trudno powiedzieć, czy w przewidywalnym czasie ludzkość osiągnie taki poziom zaawansowania technologicznego i inżynieryjnego, że możliwe będzie produkowanie świadomych maszyn, czyli urządzeń, które byłyby zdolne do doznań i przeżyć subiektywnych. Z dzisiejszej perspektywy wydaje się to raczej wątpliwe. Bardziej prawdopodobne jest jednak to, że pojawią się urządzenia i maszyny zdolne do zachowywania się tak, jak gdyby były obdarzone świadomością.

Możliwość taką przewidywał już swoim artykule Maszyna licząca a inteligencja słynny angielski matematyk i kryptolog Alan Turing. Z jednym zastrzeżeniem: chodziło mu nie tyle o maszyny świadome, co raczej o inteligentne maszyny obliczeniowe (nie odmawiał im też zdolności do myślenia rozumianego jako umiejętność prowadzenia obliczeń i sterowania zachowaniem). W obmyślonym przez siebie eksperymencie myślowym rozpatrywał on sytuację, w której maszyna zostanie zaprogramowana tak, aby w rozmowie z człowiekiem udawać, że sama nim jest (dlatego Turing nazwał swój pomysł „grą w udawanie”). Miałoby to polegać na umiejętnym – i adekwatnym do kontekstu sytuacyjnego – imitowaniu ludzkich zachowań, np. zachowań komunikacyjnych człowieka. Sprawne przejście przez maszynę takiego testu oznaczałoby w pewnym sensie, że dorównuje ona inteligencją temu, z kim prowadzi taką rozmowę. Poleganie zaś na subiektywnym i pierwszoosobowym rozumieniu świadomości – na poczuciu, że się myśli – prowadzi zaś, według Turinga, do solipsyzmu. Wtedy bowiem o tym, że ktoś coś myśli, może wiedzieć jedynie on sam i nikt inny.

Trudno do końca jednoznacznie stwierdzić, czy oszacowywanie inteligencji maszyn na podstawie ich zachowania w grze w udawanie jest równoznaczne z uznaniem, że maszyna myśli lub że zachowuje się, jak gdyby była świadoma. Być może do tego, abyśmy uwierzyli (dali się oszukać) maszynie, że jest świadoma, potrzeba czegoś więcej: zaobserwowania sporej elastyczności jej zachowań, płynności przechodzenia między zadaniami i grami, autonomii decyzyjnej czy zdolności do autokorekty zachowania. Te wszystkie cechy mogłoby zapewnić osiągnięcie przez maszyny etapu rozwoju inteligencji ogólnej (ang. general artificial intelligence). Badania nad tym typem inteligencji są dziś jednym z głównych nurtów rozwijanych w obrębie SI. Naukowcy spodziewają się, że inteligentne maszyny przyszłości będą się cechowały (1) inteligencją ogólną, czyli wielozadaniowością i elastycznym przenoszeniem rozwiązań jednej dziedziny na drugą, (2) autonomią, czyli możliwością podejmowania decyzji pozostających poza bieżącą kontrolą programisty lub operatora, a także (3) zdolnością do samoulepszania, czyli projektowania nowych urządzeń i nowych wersji własnego oprogramowania. Osiągnięcie poziomu rozwoju inteligencji ogólnej, autonomicznej i samoulepszajacej się pozwoliłoby maszynom upodobnić się do nas, a więc polepszyłoby zapewne możliwości maszyny, również jeśli idzie o symulowanie posiadania świadomości.

Jeszcze ciekawiej rysują się perspektywy rozwoju symulowania takich quasi-świadomych stanów, gdyby SI zdobyła przewagę nad człowiekiem pod względem inteligencji ogólnej. Futurystyczne, choć respektujące metody naukowe, rozważania na ten temat doprowadziły filozofa z Oxfordu i szefa placówki naukowej Future of Humanity Institute Nicka Bostroma do zaproponowania oryginalnej hipotezy superinteligencji. Twierdzi on, że SI nie przestanie się wtedy rozwijać, lecz będzie zdobywała kolejne przewagi nad człowiekiem w obszarach szybkości działania, zdolności do agregacji dużej liczby jednostek obliczeniowych oraz posiadania dodatkowych możliwości poznawczych obcych obecnemu człowiekowi. Bostrom nie pisze o tym wprost, ale można się zastanawiać, czy np. realizowanie przez superinteligencję autonomicznych celów oraz konkurowanie z człowiekiem o zasoby nie doprowadziłoby do przekroczenia magicznej granicy pomiędzy symulacją świadomości a uzyskaniem świadomości.

„Świetlane perspektywy” dla sztucznej świadomości?

Nie można dziś z całą pewnością orzec, czy inteligentne maszyny przyszłości osiągną kiedykolwiek taki poziom zaawansowania, że pojawią się u nich doznania świadome. Można natomiast spróbować określić, jak mogłaby taka przyszła świadomość maszyn wyglądać, wychodząc od zbioru ograniczeń i możliwości, jakie stwarzają układy fizyczne. Zdaniem Maxa Tegmarka, uznanego fizyka teoretycznego: „stosując […] argumenty oparte na fizyce, możemy domyślać się pewnych aspektów tego, jak czułaby się sztuczna świadomość”. Propozycja ta – leżąca gdzieś w pół drogi między rzetelną nauką a science fiction – jest ciekawa, gdyż zwraca uwagę na interesujące różnice (głównie ilościowe) pomiędzy świadomością ludzi a hipotetyczną sztuczną świadomością maszyn.

I tak, można przypuszczać, że zakres odczuć i doznań świadomych u maszyny wyposażonej w zaawansowane układy SI byłby szerszy niż u człowieka, a to ze względu na możliwość obsłużenia przez maszyny większej ilości zewnętrznych i wewnętrznych czujników i receptorów. Co więcej, według Tegmarka maszyna mogłaby doświadczać większej ilości doznań świadomych w jednostce czasu niż ludzie, „gdyż sygnały elektromagnetyczne przemieszczają się z prędkością światła, miliony razy szybciej niż sygnały neuronowe”. Można więc przypuszczać, że bazą dla sztucznej świadomości byłyby gęsto upakowane i szybko przebiegające doznania.

Zapytajmy jednak prowokacyjnie, czy tak rozumiana sztuczna inteligencja mogłaby doświadczać różnych aspektów subiektywnego doświadczenia, które biorą się z naszego biologicznego i ewolucyjnego pochodzenia (głód, pragnienie, ból, pożądanie seksualne czy instynkt samozachowawczy). Prima facie wydaje się, że założenie funkcjonalności i efektywności działania inteligentnych maszyn wykluczy zapewne w dużym stopniu sens projektowania urządzeń posiadających takie doznania. Wyjątkiem mógłby być jakiś odpowiednik – zaprogramowanego lub wytworzonego w maszynie – instynktu samozachowawczego, który umożliwiałby jej realizację złożonych i wieloetapowych zadań przed jej wyłączeniem.

Łyżka dziegciu – teoria zintegrowanej informacji

Na koniec dawka sceptycyzmu. Niestety powyższa śmiała wizja potencjału, jakim będzie dysponowała w przyszłości sztuczna świadomość, pomija, jak się wydaje, podstawowy problem dotyczący budowy i struktury materiałowej maszyn wyposażonych w SI. Wiąże się to z wcześniej sygnalizowanym problemem w orzekaniu homologii, czyli podobieństwa wewnętrznego pomiędzy mózgami ludzi i zwierząt a materiałem, z jakiego zbudowane są maszyny, i jego organizacją. Na fundamentalną różnicę między organizmami powstałymi w wyniku ewolucji a wytwarzanymi przez człowieka urządzeniami z SI zwracał już przed laty uwagę J. Searle. Generalnie pytanie dotyczy tzw. fizycznych korelatów świadomości, czyli warunków, jakie musiałyby spełniać struktura fizyczna i jej organizacja, aby były w stanie wyłonić z siebie świadomość. Pod tym względem optymizm stojący za śmiałymi wizjami sztucznej świadomości wydaje się przedwczesny.

Najciekawsze opracowanie tego supertrudnego problemu przedstawił w ostatnich latach psychiatra i neuronaukowiec Giulio Tononi. Zgodnie z opracowaną przez niego „teorią zintegrowanej informacji” materia, która jest nośnikiem świadomości, musi być odpowiednio zorganizowana, m.in. musi mieć odpowiedni poziom integracji reprezentowany za pomocą matematycznej miary i przedstawiany symbolicznie za pomocą greckiej litery Φ (Phi). Organizacja mózgów ludzkich (i zwierzęcych) cechuje się dużą liczbą Φ, natomiast organizacja układów krzemowych i elektronicznych cechuje się małym poziomem integracji. Jest to związane z tym, że w biologicznym mózgu występuje wiele różnych typów neuronów, wiele heteronomicznych sieci połączeń nerwowych wyposażonych w pętle zwrotne, a zasady przenoszenia sygnałów elektrycznych wzdłuż aksonu komórki nerwowej za pomocą fali depolaryzacyjnej różnią się od przepływu prądu w zwykłym przewodzie elektrycznym. Z tego względu odwzorowanie struktury połączeń ludzkiego mózgu w postaci symulacji tej struktury w komputerze przyszłości o znanej nam dzisiaj architekturze nie wytworzy w niej świadomości. Pewną nadzieję stwarzają natomiast prace nad komputerami neuromorficznymi, naśladującymi działanie ludzkiego mózgu, które są jednak ciągle w powijakach.

Piotr Przybysz – filozof i kognitywista; doktor habilitowany, prof. UAM na Wydziale Filozoficznym Uniwersytetu Adama Mickiewicza w Poznaniu. Zajmuje się neuroestetyką i kognitywistyką społeczną. Zainteresowany problemami rozwoju SI, filozofią analityczną, metafizyką i filozofią polityki.

Piotr Przybysz – filozof i kognitywista; doktor habilitowany, prof. UAM na Wydziale Filozoficznym Uniwersytetu Adama Mickiewicza w Poznaniu. Zajmuje się neuroestetyką i kognitywistyką społeczną. Zainteresowany problemami rozwoju SI, filozofią analityczną, metafizyką i filozofią polityki.

Tekst jest dostępny na licencji: Uznanie autorstwa-Na tych samych warunkach 3.0 Polska.

W pełnej wersji graficznej jest dostępny w pliku PDF.

< Powrót do spisu treści numeru.

Ilustracja: Małgorzata Uglik

Skomentuj